https://scikit-learn.org

대표적인 파이썬 머신러닝 모듈

다양한 머신러닝 알고리즘 제공

다양한 샘플 데이터를 제공

머신러닝 결과를 검증하는 기능을 제공

BSD 라이센스이기 때문에 무료로 사용 및 배포가 가능

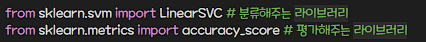

1. LinearSVC

* 클래스를 구분으로 하는 분류 문제에서 각 클래스를 잘 구분 하는 선을 그려주는 방식을 사용하는 알고리즘

* 지도학습 알고리즘을 사용하는 학습 전용 데이터와 결과 전용 데이터를 함께 가지고 있어야 사용이 가능한 알고리즘

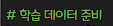

learn_data = [[0,0], [1,0], [0,1],[1,1]]

learn_label = [0,0,0,1]

svc = LinearSVC()

svc.fit(learn_data, learn_label)

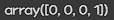

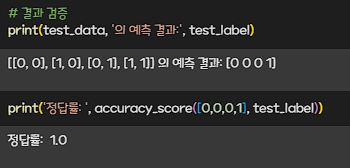

test_data = [[0,0], [1,0], [0,1],[1,1]]

test_label = svc.predict(test_data)

test_label

'머신러닝, 딥러닝' 카테고리의 다른 글

| GPU 사용법 (0) | 2023.07.06 |

|---|---|

| tensor의 변환 (0) | 2023.07.06 |

| pytorch(scalar, vector, matrix, tensor) (0) | 2023.07.06 |

| Iris DataSet (0) | 2023.06.14 |

| 머신러닝 (0) | 2023.06.13 |